01 概述隨著大語言模型(LLM)各領域的廣泛應用,我們迫切需要了解其中潛在的風險和威脅。《LLM安全警報:六起真實案例剖析,揭露敏感信息泄露的嚴重後果》[1]從真實案例中指出了LLM敏感信息泄露的嚴

一、結論寫在前面論文旨在建立一個基準,用於評估像LLama 2、GPT-3.5和GPT-4這樣的大型語言模型在解決農業領域復雜問題方面的能力。通過評估它們在使用RAG或/和微調時的表現,該研究對LLM

選擇正確的LLM推理棧意味著選擇適合你的任務的正確模型,並配以適當的推理代碼在適當的硬件上運行。本文介紹了流行的LLM推理堆棧和設置,詳細說明其推理的成本構成;並討論當前的開源模型以及如何充分利用它們

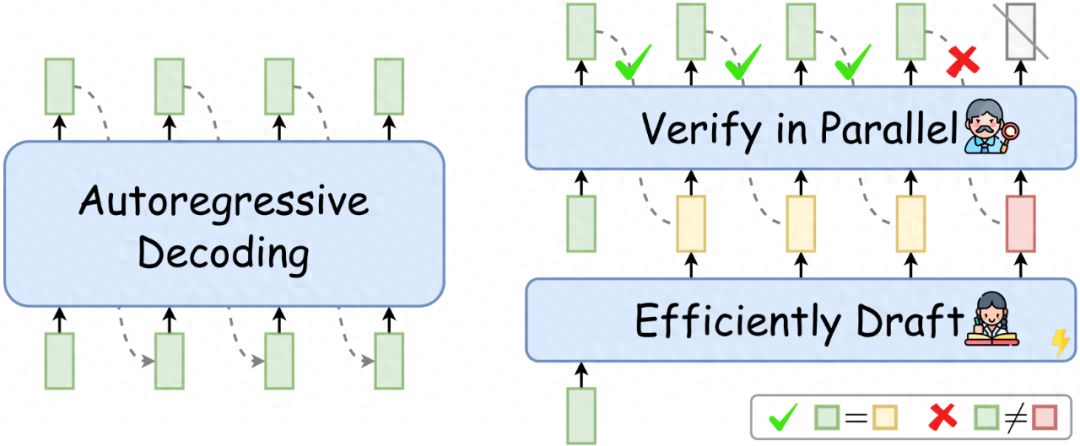

近一段時間以來,工業界和學術界都對大型語言模型(LLM)的內部運行機理進行了深入的研究和探索。這種基礎理論研究對於大模型更安全更廣泛的應用落地具有重要意義。目前較為流行的LLM架構仍然基於自回歸式的T

思想鏈(CoT)對於提高大型語言模型(LLM)的推理能力具有重要意義。 然而,CoT 的有效性與提示中推理步驟的長度之間的相關性仍然很大程度上未知。 為了闡明這一點,多傢研究機構(西北大學、羅格斯大學

好久不見!在這裡跟大傢分享我們最近關於推測解碼(Speculative Decoding)的一篇綜述:Unlocking Efficiency in Large Language Model Infe

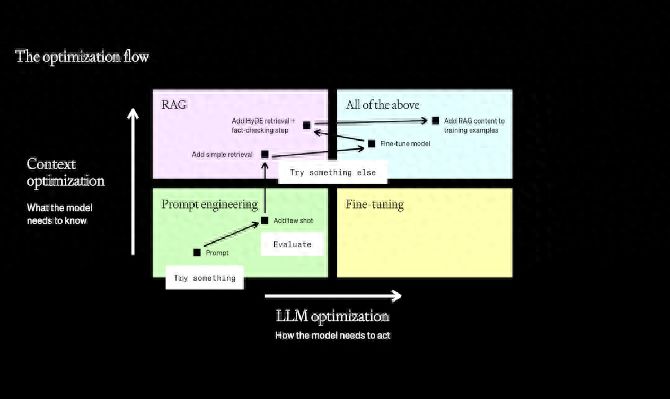

傳統廠商在面對自身企業的具體場景下,切入LLM 整合業務應用的時候,主要有兩種方案供選擇,RAG 與 Finetune. 那麼在企業級應用場景下,到底是應該選擇RAG 還是Finetune 呢?下面由

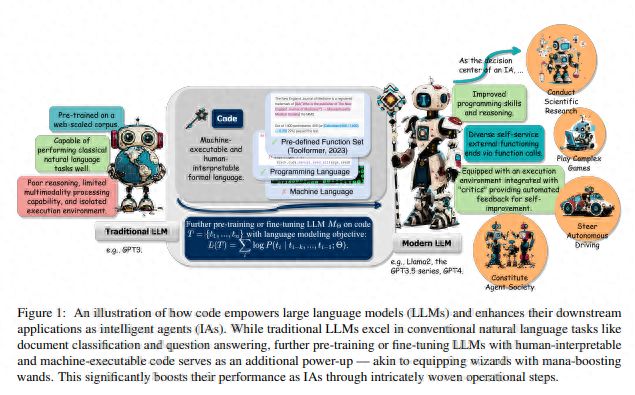

要點:1. 代碼預訓練提升LLM在推理能力上的表現,能應用於更復雜的自然語言任務。2. 代碼生成結構化的中間步驟,可以通過函數調用連接到外部執行終端。3. 利用代碼編譯和執行環境提供了更多樣化的反饋信

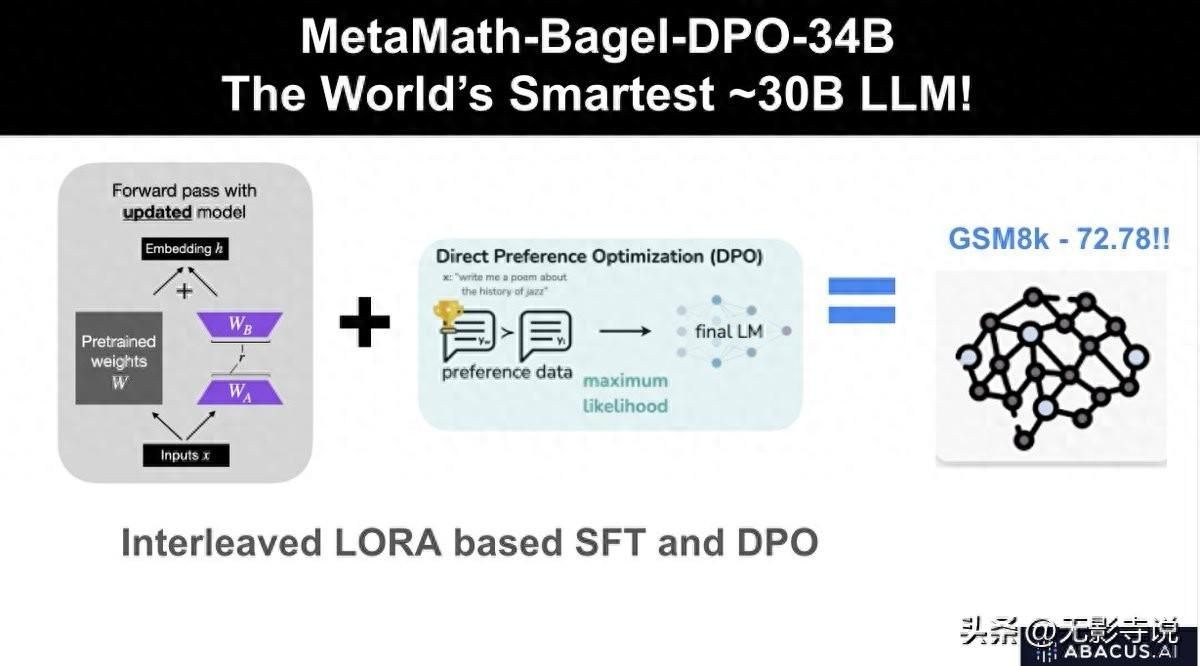

一、結論寫在前面LLM需要改進的一個迷人領域是推理。今年將看到一些新穎的作品。一個很感興趣領域是數學推理。LLM在與數學相關的問題上表現糟糕。如何在這個領域改進它們呢?我懷疑我們可能需要更好的架構並收

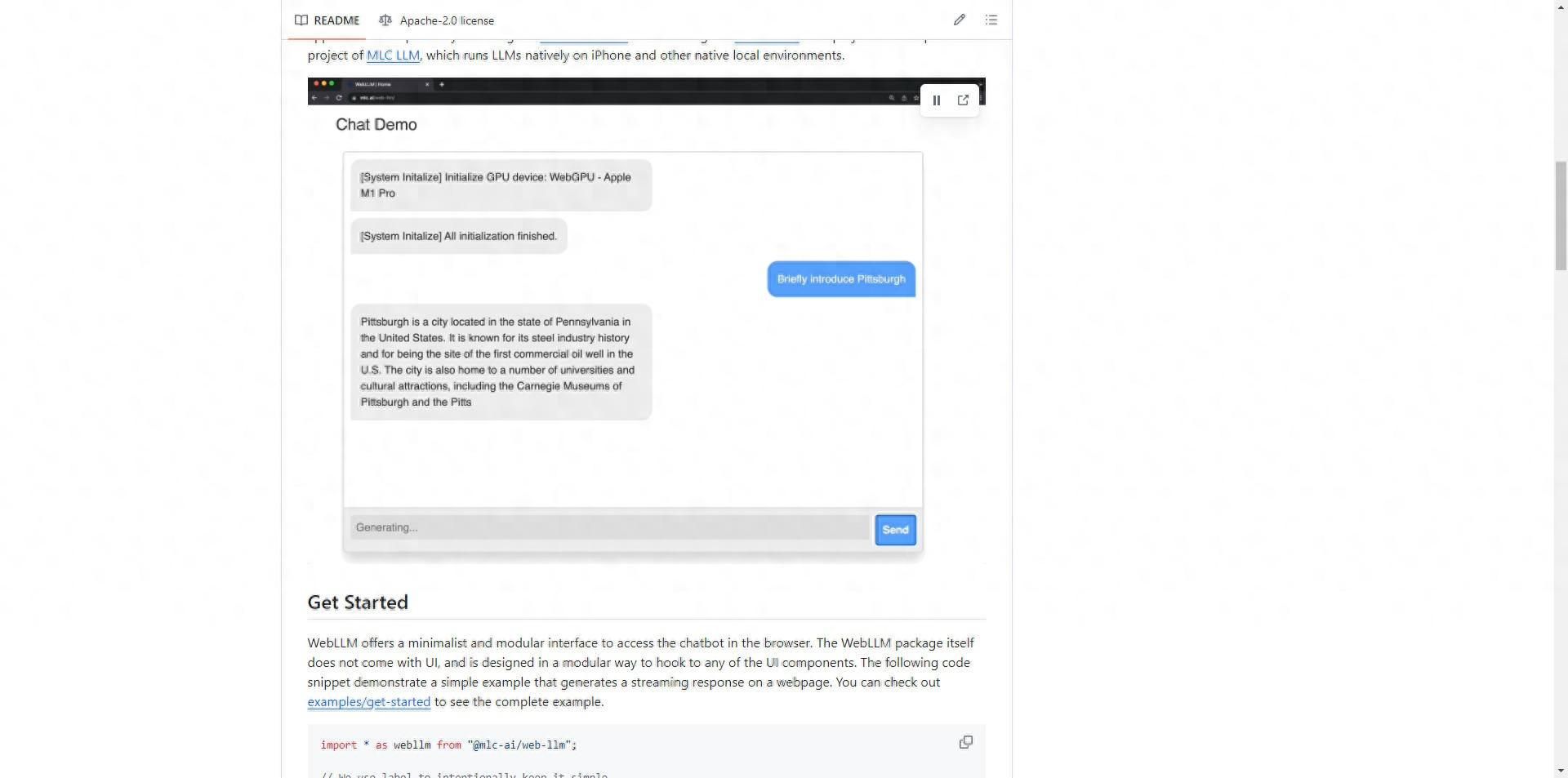

該項目利用WebGPU加速,無需服務器支持,所有操作都在瀏覽器內運行。 主要特點:支持多種模型: 支持多種模型,包括Llama 2 7B/13B、Llama 2 70B、Mistral 7B以及Wiz